Hvorfor giver HDMI-DVI et skarpere billede end VGA?

Med al den store hardware, vi har til rådighed i disse dage, ser det ud til, at vi skal nyde god kvalitet, uanset hvad, men hvad hvis det ikke er tilfældet? Dagens SuperUser Q & A indlæg søger at rydde op for en forvirret læseren.

Dagens Spørgsmål & Svar session kommer til os med venlig hilsen af SuperUser-en underafdeling af Stack Exchange, en community-driven gruppe af Q & A-websteder.

Foto høflighed af lge (Flickr).

Spørgsmålet

SuperUser læser alkamid ønsker at vide, hvorfor der er en mærkbar forskel i kvalitet mellem HDMI-DVI og VGA:

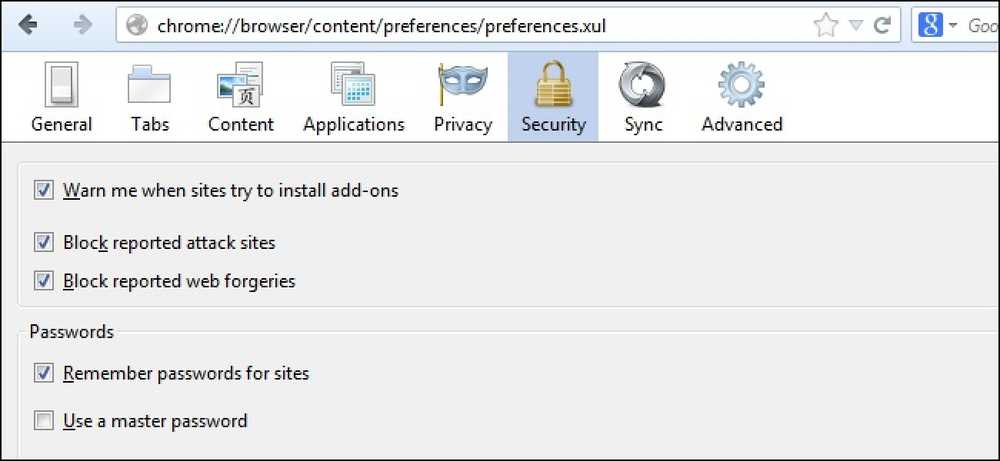

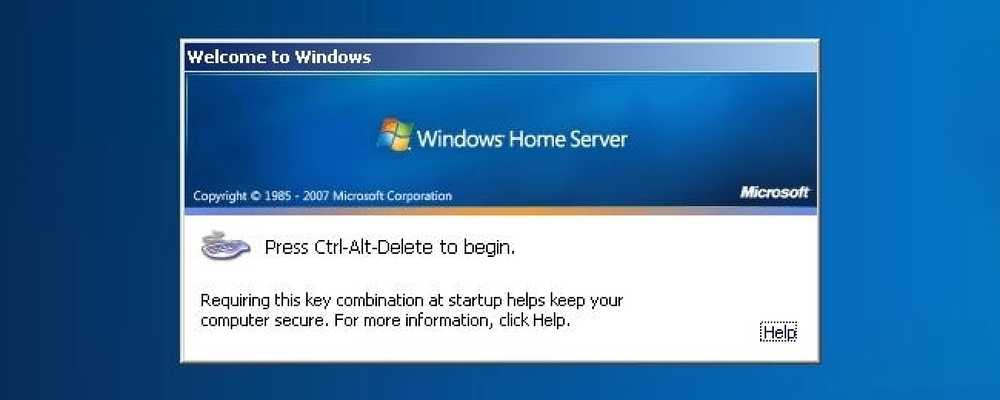

Jeg har en Dell U2312HM skærm tilsluttet en Dell Latitude E7440 bærbar computer. Når jeg forbinder dem via en bærbar computer -> HDMI-kabel -> HDMI-DVI adapter -> skærm (skærmen ikke har en HDMI-stik), er billedet meget skarpere end hvis jeg tilslutter via laptop -> miniDisplayPort-VGA adapter -> VGA kabel -> skærm.

Forskellen er vanskelig at fange med et kamera, men se mit forsøg på det nedenfor. Jeg prøvede at spille med indstillingerne lysstyrke, kontrast og skarphed, men jeg kan ikke få samme billedkvalitet. Beslutningen er 1920 * 1080 med Ubuntu 14.04 som mit operativsystem.

VGA:

HDMI:

Hvorfor er kvaliteten anderledes? Er det iboende for disse standarder? Kan jeg få et defekt VGA-kabel eller mDP-VGA-adapter?

Hvorfor er der en forskel i kvaliteten mellem de to?

Svaret

SuperUser bidragsydere Mate Juhasz, Youngwt, og Jarrod Christman har svaret for os. Først op, Mate Juhasz:

VGA er det eneste analoge signal blandt de ovennævnte, så det er allerede en forklaring på forskellen. Brug af adapteren kan forværre kvaliteten yderligere.

Nogle yderligere læsning: HDMI vs DisplayPort vs DVI vs. VGA

Efterfulgt af svaret fra youngwt:

Under forudsætning af at lysstyrke, kontrast og skarphed er de samme i begge tilfælde, kan der være to andre grunde til, at teksten er skarpere med HDMI-DVI.

Den første er allerede angivet, VGA er analog, så det skal gennemgå en analog til digital konvertering inde i skærmen. Dette vil teoretisk forringe billedkvaliteten.

For det andet, forudsat at du bruger Windows, er der en teknik kaldet ClearType (udviklet af Microsoft), som forbedrer udseendet af tekst ved at manipulere subpixelerne på en LCD-skærm. VGA blev udviklet med CRT-skærme i tankerne, og begrebet underpixel er ikke det samme. På grund af kravet om ClearType at bruge en LCD-skærm og det faktum, at VGA-standarden ikke fortæller værten, vil specifikationerne på displayet blive deaktiveret med en VGA-forbindelse.

Jeg husker at høre om ClearType fra en dens skabere på en podcast til This (). Developers (). Life () IIRC, men denne Wikipedia artikel støtter også min teori. Også HDMI er bagudkompatibel med DVI og DVI understøtter Electronic Display Identification (EDID).

Med vores sidste svar fra Jarrod Christman:

De andre gør nogle gode punkter, men hovedårsagen er en tydelig klok og fase mismatch. VGA er analog og er underlagt interferens og mismatch af de analoge sende- og modtagelsessider. Normalt ville man bruge et mønster som dette:

Ur og fase

Derefter justeres skærmens ur og fase for at få den bedste match og det skarpeste billede. Men da det er analogt, kan disse justeringer ske over tid, og derfor bør du ideelt set bare bruge et digitalt signal.

Har du noget at tilføje til forklaringen? Lyde af i kommentarerne. Vil du læse flere svar fra andre tech-savvy Stack Exchange brugere? Tjek den fulde diskussionstråd her.